Apple tworzy system wykrywania pedofilii

Amerykański potentat technologiczny Apple pracuje nad nowym systemem sztucznej inteligencji CSAM, która będzie wykrywać i zgłaszać użytkowników, którzy przechowują treści pedofilskie w chmurze iCloud. Algorytm ma oflagowywać konta użytkowników, które będą posiadać materiały zgodne z bazą treści CSAM. Identyfikacja ta ma odbywać się na podstawie haszy. Dzięki temu firma będzie mieć możliwość zgłaszania posiadaczy produktów Apple do NCMEC (National Center for Missing and Exploited Children).

Apple podkreśla jednak, że przed zgłoszeniem materiały zostaną zweryfikowane. Firma ponadto nie zamierza gromadzić żadnych informacji na temat treści, które mogą mieć charakter pedofilski, ani nie będzie mieć dostępu do metadanych, czy samych cech wizualnych materiałów, dopóki te nie przekroczą progu alarmującego zdefiniowanego przez bazę danych CSAM. Dopiero wtedy Apple będzie zgłaszać możliwość popełnienia przestępstwa do odpowiednich organów.

Amerykański potentat technologiczny twierdzi także, że algorytm CSAM jest niezwykle skuteczny i całkowicie bezpieczny. Szansa na błędne rozpoznanie zdjęcia jako treści pedofilskiej ma wynosić jeden na miliard. System jest wspierany technologią kryptograficzną PSI, która pozwala na wykrycie fotografii bez ujawniania jej zawartości. Z kolei technologia haszująca używana w systemie to NeuralHash. Jest to algorytm, który analizuje zdjęcia i konwertuje je w unikalny ciąg cyfr, który odpowiada poszczególnym obrazom w bazie danych CSAM.

Nowy system CSAM Apple – zagrożenie dla prywatności?

Pomimo zapewnień firmy, nowy system nie przypadł każdemu do gustu. W internecie podnosi się larum, iż może on być poważnym zagrożeniem dla naszej prywatności. W szczególności, że użytkownicy nie będą mieć dostępu do bazy danych CSAM i nie będą wiedzieli, które zdjęcia oflagowane zostały jako treści pedofilskie. Według dr. Piotra Łuczuka, miedioznawcy i eksperta ds. cyberbezpieczeństwa, nikt przy zdrowych zmysłach nie będzie negować rozwiązań mających na celu ograniczenie publikowanych i udostępnianych treści o charakterze pedofilskim. Jednocześnie dr Łuczuk widzi tutaj potencjalne zagrożenie dla naszego bezpieczeństwa i wyjaśnia, dlaczego użytkownicy Apple mogą czuć się niepewnie.

– Proponowane przez firmę Apple rozwiązanie należałoby traktować pozytywnie, jako formę zabezpieczenia przed zagrożeniami płynącymi z cyberprzestrzeni – twierdzi dr Piotr Łuczuk. –Oczywiście pojawiają się uzasadnione obawy o kwestie związane z poszanowaniem prywatności i wszelkiego rodzaju błędy tagującego zdjęcia algorytmu. Jednak twórcy tego rozwiązania przekonują, że wprowadzane rozwiązanie jest w pełni bezpieczne – mówi dr Piotr Łuczuk.

Dr Łuczuk wspomina też, że ograniczenie zaufania po stronie konsumentów może się brać z historii koncernu Cupertino. Ten ma za sobą dość nieprzyjemne doświadczenia związane z kwestią ochrony prywatności. Chodzi tutaj oczywiście o ujawnioną przez Edwarda Snowdena skalę inwigilacji użytkowników w ramach systemu PRISM. Wówczas gromadzono dane z serwerów m.in. Google, Facebook, Yahoo, Paltalk, AOL, Skype, YouTube i właśnie Apple.

– Stąd moim zdaniem wynikają podstawowe obawy użytkowników związane z wprowadzanym nowym rozwiązaniem. W teorii wszystko wygląda obiecująco, jednak należy mieć świadomość, że algorytm Apple będzie potrzebował w zasadzie pełnego dostępu do wszystkich zdjęć znajdujących się w smartfonie i to jeszcze przed ich archiwizacją w iCloud. Wymaga to potężnej mocy obliczeniowej i co uzasadnione stwarza ogromne pole do nadużyć. Miejmy nadzieję, że Apple odrobiło lekcję w kwestii poszanowania prywatności – dodaje dr Łuczuk.

Z kolei socjolog i nauczyciel akademicki Uniwersytetu Gdańskiego dr Wojciech Edmund Zieliński, podkreśla, że jednoznaczna i bezdyskusyjna odpowiedź w tej sprawie jest niemożliwa. Według niego szeroko pojęty informatyczny wymiar życia tj. cyberprzestrzeni nie pozwala w prosty sposób oddzielać tego, z czego chcemy dla własnego i wspólnego dobra korzystać, od tego, co postrzegamy jako dla nas niepokojące lub wprost niepożądane.

– Ale w pewnym sensie to jest problem „odwieczny”, wszak nie od dzisiaj rozmaite nasze wytwory najzwyczajniej również utrudniają nam życie. Błędem byłoby jednak pozostawianie tego zagadnienia jakiemuś „swojemu biegowi”, z nadzieją, że sygnalizowane obawy o nieuprawnioną inwigilację i problemy z tych obaw wynikające rozwiążą się same. Im bardziej otwarta, krytyczna i wnikliwa będzie ekspozycja i dyskusja wszelkich pojawiających się wątpliwości, tym większe prawdopodobieństwo, że dobre rozwiązania informatyczne, organizacyjne itp. będą demaskowały i ograniczały pola rozmaitych, możliwych lub faktycznych nadużyć – podkreśla dr Zieliński.

Apple chce informować rodziców o tym, że ich dzieci oglądają porno

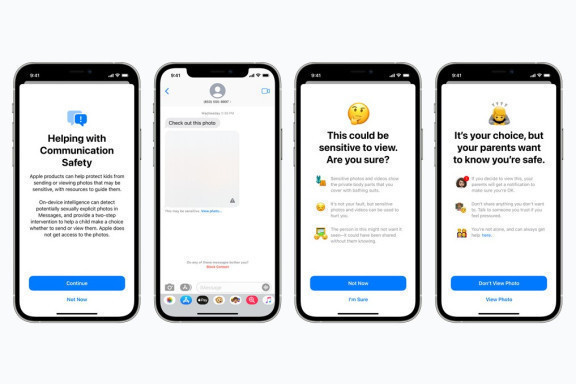

Marka de facto wprowadza szereg aktualizacji do swojego systemu i poza wykrywaniem treści pedofilskich, chce także rozszerzyć opcję kontroli rodzicielskiej. Firma ma zamiar udostępnić rodzicom możliwość zablokowania zdjęć erotycznych dla użytkowników poniżej 18 roku życia i wysyłać powiadomienia, kiedy np. dziecko w wieku poniżej 13 lat obejrzy bądź prześle tego typu fotografie.

Jeśli rodzice wyrażą zgodę na tę opcję, iPhone’y nieletnich użytkowników będą skanować zdjęcia przychodzące i wychodzące za pomocą klasyfikatora obrazów. Algorytm w tym przypadku ma oflagowywać treści o „charakterze jednoznacznie seksualnym”. Jeśli system wykryje takie zdjęcie, zasłania je i pyta użytkownika, czy naprawdę chce je wysłać bądź wyświetlić. Jeśli jednak użytkownik jest osobą małoletnią, tj. poniżej 13 roku życia, rodzic otrzyma specjalne powiadomienie, iż dany materiał erotyczny został przez nie wyświetlony. Firma zapewnia, że w tym przypadku system nie zgłasza niczego ani do moderatorów Apple, ani do zewnętrznych podmiotów.

Nowa aktualizacja iOS bardzo mocno podzieliła konsumentów, ale również ekspertów od cyberbezpieczeństwa czy kryptografii. Część z nich, jak Mihira Bellare, David Forsyth czy Dan Boneh uważają, iż Apple wykonał krok w dobrym kierunku. Wielu specjalistów czy organizacji wyraża jednak sprzeciw czy swoje obawy w związku z nowymi algorytmami firmy. Tymi postanowiło się podzielić aż 36 organizacji i 7427 developerów i ekspertów ds. cyberbezpieczeństwa, którzy podpisali list otwarty do amerykańskiej firmy.

W liście czytamy: „Podczas gdy wykorzystywanie dzieci jest poważnym problemem, a wysiłki zmierzające do jego zwalczania są niemal bezsprzecznie podejmowane w dobrych intencjach, propozycja Apple wprowadza backdoora, który grozi podważeniem fundamentalnej ochrony prywatności wszystkich użytkowników produktów Apple. Proponowana technologia działa poprzez ciągłe monitorowanie zdjęć zapisanych lub udostępnionych na iPhonie, iPadzie lub Macu użytkownika. Jeden system sprawdza, czy w pamięci iCloud zostanie wykryta pewna liczba budzących zastrzeżenia zdjęć, i ostrzega o tym podmioty publiczne. Inny powiadamia rodziców dziecka, jeśli iMessage jest używany do wysyłania lub odbierania zdjęć, które algorytm uważa za zawierające nagość. Jako że obie kontrole są przeprowadzane na urządzeniu użytkownika, mogą one potencjalnie ominąć wszelkie szyfrowanie typu end-to-end, które w przeciwnym razie chroniłoby prywatność użytkownika.”

Apple jednak zdementowało obawy twórców listu i prosi swoich użytkowników o zaufanie w tej kwestii. Czas pokaże, jak bardzo skutecznym jest nowy algorytm firmy.