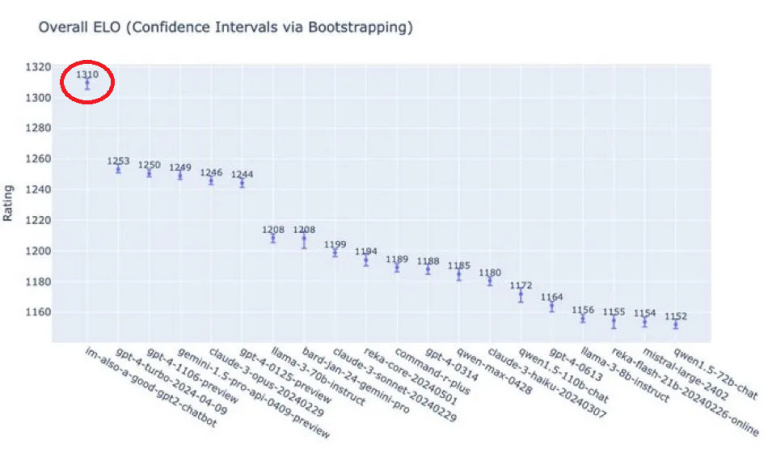

Poniższywykres to wykres Elo z areny LMSys. Spójrzcie na liczbę zakreśloną na czerwono – to tajemniczy model „im-also-a-good-gpt2-chatbot”, który krąży po Twitterze.

To również nowy model OpenAI: GPT-4o, nazywany powszechnie Omni (to „o” po czwórce to właśnie skrót od słowa omni). Jak sądzili pierwsi użytkownicy po interakcji z modelami gpt2-chatbot, jest on lepszy niż GPT-4. I wiecie co? Już teraz wiemy, że mieli rację. Trudno było przypuszczać, że nowa odsłona osiągnie wynik aż o 60 punktów Elo lepszy od GPT-4 turbo. A to ten model pozostawał najlepszy na świecie. Aby nie być gołosłownym, dokonajmy porównania z modelami innych firm – Gemini 1.5 Pro, Claude 3 i Llama 3-70B (odpowiednio 4, 5 i 7) – żadnemu z nich nie udaje się osiągnąć poziomu wydajności 1,5-letniego modelu (z niedawnymi aktualizacjami).

Oprócz tego, że Omni jest najlepszy, ważne jest również to, że jest darmowy. Użytkownicy, którzy od lat korzystają z GPT-3.5, mogą nagle uzyskać dostęp do GPT-4o – o kilka iteracji lepszego – całkowicie za darmo. To radykalna zmiana w dynamice biznesowej całego sektora. To reset wszystkich małych sprzeczek i drobnych potyczek, które miały miejsce do tej pory. To wymuszony przegląd wszelkich krótkoterminowych perspektyw dla wszystkich konkurentów OpenAI.

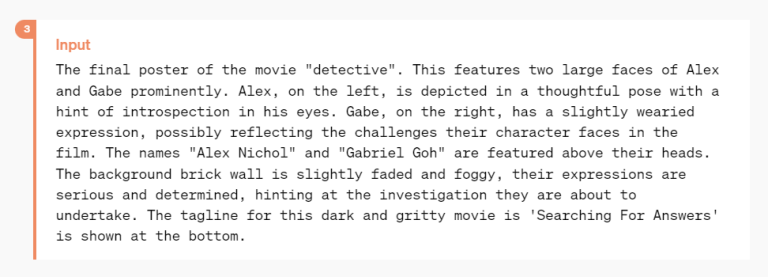

Dlaczego?

Czy to naprawdę jest za darmo?

Kiedy OpenAI ogłosiło ChatGPT w listopadzie 2022 roku z GPT-3.5 jako modelem backendu, (prawie) wszyscy byliśmy w szoku. Przede wszystkim dlatego, że doświadczyliśmy przeskoku z GPT-3. Oczywiście, pod warunkiem, że byliśmy w tej niewielkiej części społeczeństwa, która z GPT-3 korzystała. Pozostali po raz pierwszy w życiu mogli zetknąć się z tak zaawansowanym narzędziem. W tamtym czasie GPT-3.5 był rzeczywiście najlepszym modelem dostępnym jako chatbot za darmo. Wielu analityków zastanawiało się, jak OpenAI może sobie na to pozwolić, skoro miliony użytkowników codziennie wykorzystują model do swoich najprzeróżniejszych potrzeb. Podejrzewano, że całe przedsięwzięcie finansowane jest z pieniędzy Microsoftu.

Cztery miesiące później OpenAI wydało GPT-4 i przekształciło go w poziom subskrypcji ChatGPT o wartości 20 USD miesięcznie, aby pokryć koszty.

Większość ludzi pozostała przy darmowym ChatGPT, ale ci, którzy byli skłonni wydać kilka dolarów na aktualizację, szybko zdali sobie sprawę, że była to okazja. Oczywiście, darmowym użytkownikom nigdy nie przyszło do głowy, że GPT-4, zaledwie pół wersji powyżej tego, czego używali, może być o wiele lepszy.

To był błąd OpenAI. Błędna kalkulacja tego, ile ludzie byliby skłonni zapłacić za ulepszenie, którego nie mogli posmakować. Ale był to błąd konieczny, ponieważ OpenAI nie mogło sobie pozwolić – lub nie chciało – aby uczynić GPT-4 darmowym. Teraz, dzięki poprawie wydajności w GPT-4o, mogą to zrobić. Udostępnienie najlepszego modelu na świecie za darmo wydaje się być druzgocącym posunięciem dla wszystkich konkurentów, którzy teraz próbują zarabiać na subskrypcjach wartych 20 USD miesięcznie, a oferujących znacznie gorsze i mniej znane modele.

Ważna informacja dla tych, którzy do tej pory płacili za GPT-4: niektóre korzyści dla Ciebie zostają utrzymane, takie jak 5-krotny limit użytkowania.

GPT-4o: natywnie multimodalnym modelem end-to-end

Co oznacza ten trudny, długi i zdecydowanie zbyt mocno najeżony slangiem IT zwrot? Ni mniej, ni więcej tylko to, że Omni jest w stanie w płynny sposób przetwarzać tekst, dźwięk, głos, wideo i obrazy jednocześnie. Dla porządku trzeba dodać, że Gemini firmy Google DeepMind też już to potrafi. Warto docenić asystenta AI podobnego do filmowego modelu Her: GPT-4o ma świetne możliwości głosowe oraz wideo. Bardzo dobrze reaguje na emocje, z wyczuciem stosuje ludzkie maniery i jest niezwykle szybki. Niemal 100% swoich operacji wykonuje w czasie rzeczywistym. Możliwe jest teraz m.in. natychmiastowe tłumaczenie.

To właśnie jest ta multimodalność – poprzedni tryb głosowy ChatGPT działał modułowo W przeciwieństwie do poprzedniego trybu głosowego dla ChatGPT, który był podejściem modułowym (najpierw przetwarzał mowę na tekst, następnie tekst na tekst, by wreszcie ponownie zamienić tekst na mowę), GPT-4o działa kompleksowo.

GPT-4o to jeden model end-to-end dla tekstu, wizji i dźwięku: wszystkie dane wejściowe i wyjściowe są przetwarzane przez tę samą sieć neuronową. Jak deklarują twórcy Omni, z uwagi na fakt, że GPT-4o jest ich pierwszym rozwiązaniem łączącym wszystkie te modalności, to wszystkie jego możliwości czy ograniczenia są wciąż odkrywane.

Trzy subiektywne uwagi

– Nowy tryb głosowy (i wideo) to najlepszy interfejs obliczeniowy, jakiego kiedykolwiek używałem. Da się poczuć, że jest to sztuczna inteligencja jak z filmów. Dla mnie to wciąż nieco zaskakujące, że GPT-40 jest prawdziwy. Osiągnięcie czasu reakcji i ekspresyjności na poziomie ludzkim okazuje się być dużą zmianą. Oryginalny ChatGPT pokazał, co jest możliwe w przypadku interfejsów językowych; ta nowa rzecz jest zupełnie inna. Jest szybki, inteligentny, zabawny, naturalny i pomocny – tak o możliwościach głosowych czy wideo Omni napisał na blogu OpenAI Sam Altman, dyrektor generalny firmy.

A co sądzimy my po pierwszych dniach użytkowania nowego dzieła Altmana i spółki?

Po pierwsze, zaoferowanie najbardziej zaawansowanego modelu sztucznej inteligencji na świecie za darmo to posunięcie, na które nie pozwoliła sobie do tej pory żadna inna firma. W ten sposób OpenAI nie tylko na nowo wytycza reguły gry, ale również unicestwia zasady obowiązujące do tej pory i respektowane przez innych graczy z rynku.

Po drugie, możliwości głosowe/wideo omawianego modelu – a przede wszystkim ludzkie maniery, emocje i szybkość działania w czasie rzeczywistym – mogą przekonać Ciebie do tego, żeby wykorzystać Omni jako swojego asystenta. Nawet jeśli do dzisiaj taka wizja asystenta AI była dla Ciebie nie do zaakceptowania.

Po trzecie, jeśli OpenAI sfinalizuje umowę z Apple i uda mu się zaimplementować GPT-4o, który zastąpi Siri, będzie to koniec gry dla Google, Meta, Anthropic.

Bliższe spojrzenie

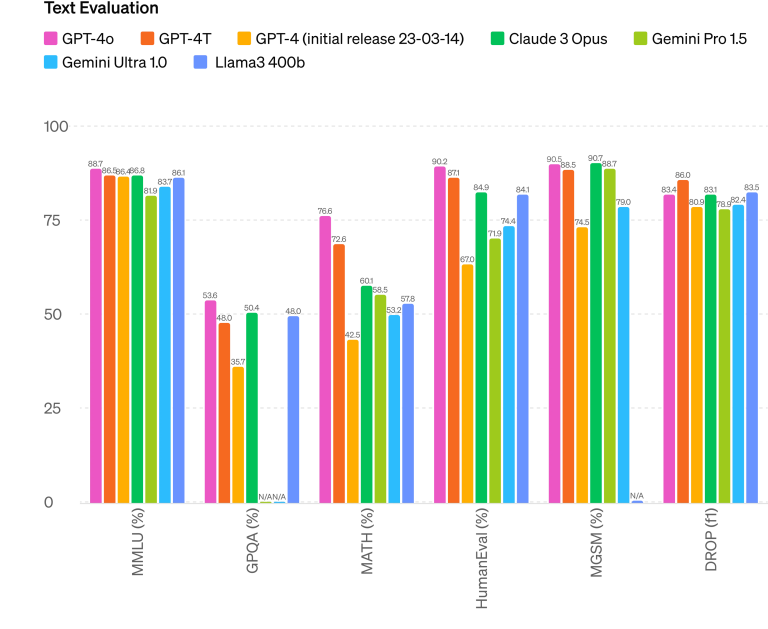

Chociaż arena LMSys jest obecnie preferowaną oceną opinii publicznej, OpenAI przetestował GPT-4o za pomocą tradycyjnych benchmarków. Jak wynika z poniższego wykresu, model jest lepszy niż wszystkie pozostałe. Chociaż akurat tutaj nie widać tej różnicy, którą sygnalizowaliśmy na wstępie tekstu – różnicy 60 punktów w Elo.

Czy to się zmieni, gdy GPT-5 ujrzy światło dzienne? Jeśli obecny model biznesowy sprawdzi się, dla OpenAI będzie to świetne posunięcie zarówno utrudniające życie konkurentom, jak i przynoszące korzyści użytkownikom. Zwłaszcza że Altman deklaruje, że w ChatGPT nie będzie reklam.

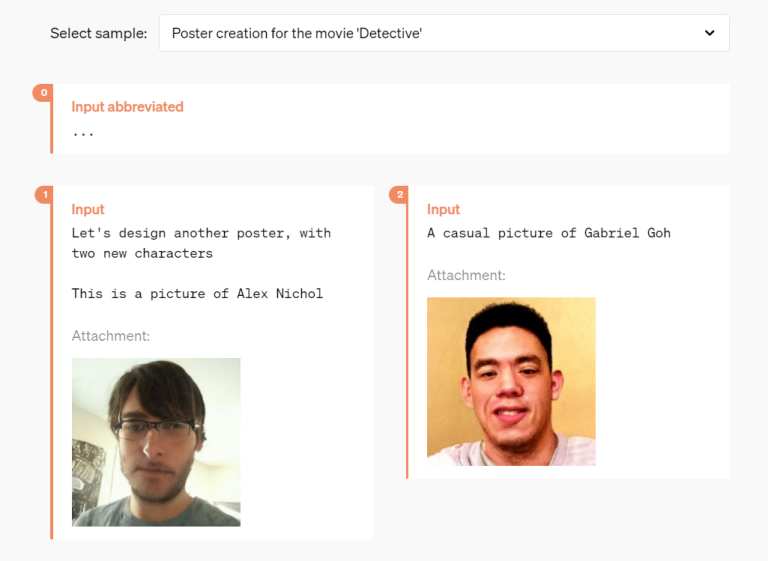

O możliwościach, o których nie wspomniano w demo, możecie przeczytać w poście na blogu OpenAI. Oto jeden przykład:

– Myślę, że ludzie źle rozumieją GPT-4o. To nie jest model tekstowy z załącznikiem głosowym lub obrazowym. To natywnie multimodalny model tokenów wejściowych, multimodalny model tokenów wyjściowych. Chcesz, żeby mówił szybko? Po prostu poproś go o to. Chcesz przetłumaczyć tekst na odgłosy wieloryba? Po prostu użyj kilku przykładowych ujęć. Każda sztuczka, którą stosowałeś w książce, której używałeś do tekstu, działa również w przypadku wejścia audio, wyjścia audio, percepcji obrazu, percepcji wideo i generowania obrazu – zaznacza Will DePue z OpenAI.

GPT-4o na poziomie 1310 Elo vs GPT-4 turbo na poziomie 1253 (i inne poniżej) nie jest aktualizacją „złamaliśmy skalę”. Ale to update na tyle znaczący, by rozwiać wszelkie myśli o firmach zatrzymujących swoje modele LLM na poziomie wydajności GPT-4 i tłumacząc to ograniczeniami algorytmicznymi. Jeszcze do niedawna dało się słyszeć głosy, że owe ograniczenia można pokonać tylko dzięki nowemu paradygmatowi.

Jak pokazuje przykład OpenAI – przekroczenie granic było możliwe. Mimo wszystkich zachwytów nad premierowym GPT-4o, mądrze jest poczekać na głosy sceptyków, którzy przetestują nowy model i wynajdą jego wady.