Testy a/b są podstawowym narzędziem porównywarki cen Okazje.info, jakie stosujemy do oceny skuteczności realizowanych przez nas projektów. W takich testach każdorazowo bierze udział do miliona użytkowników, a wzrost konwersji kilkukrotnie przekroczył 10%.

Jak wskazują badania „Megapanel PBI/Gemius” za luty 2014, Grupa Okazje.info zajmuje obecnie drugie miejsce w Polsce w kategorii e-commerce z 2,1 milionami rzeczywistych użytkowników. Dzięki takiej skali ruchu w testach bez problemu osiągamy istotność statystyczną, która jest miarą ich wiarygodności.

Zdjęcie royalty free z Fotolia

Na czym polegają testy a/b?

W Okazje.info opracowaliśmy autorski mechanizm testów. Nasza porównywarka cen ma dość rozbudowaną strukturę, dlatego dużą wagę przywiązujemy do czasu ładowania, który wydłużyłby się przez wprowadzenie dodatkowego systemu. Kiedy stosujemy własną technologię, zdecydowanie łatwiej jest nam również przeprowadzić integrację z systemami wewnętrznymi.

Nasze narzędzie zintegrowane jest z Google Analytics dzięki użyciu zmiennych niestandardowych (kod _setCustomVar). W Universal Analytics zastąpiony został przez tzw. custom metrics. Zapisujemy w niej unikalny numer testu i informację o wersji strony, którą widzi użytkownik. Te same dane zapisują się w pliku cookie – gdy użytkownik powraca na stronę w trakcie testów, widzi tę samą wersję – odczytaną z ciastka.

Rozpoznawanie zmiennych w Analyticsie wygląda tak:

W teście 5EA9 wyniki wskazują na 900 tysięcy odwiedzin z wyraźnym podziałem na dwie grupy użytkowników.

Wpływ czynników zewnętrznych a testy a/b

Doświadczenie pokazało nam, że bez udziału testów a/b ocena efektywności jest nie tylko bardzo trudna, czasem wręcz niemożliwa, ale i podatna na błędy. Mimo że ich wdrożenie jest czasochłonne, stanowią ważny element optymalizacji działań. Dają również jednoznaczną ocenę danego projektu, uwzględniając m.in. poziom konwersji czy przychodu.

Testy zapewniają minimalizowanie wpływu czynników zewnętrznych. Często są nimi na przykład pogoda, święta, wolne od pracy dni albo sezonowość ruchu i konwersji dla różnych kategorii produktowych. Należy pamiętać też o zmianach w ruchu, które są wynikiem wahania jego źródeł, ich efektywności, startujących kampanii, zmian w ruchu organicznym. A to tylko kropla w morzu.

Nieuniknione są także problemy w postaci awarii czy błędów. Wliczyć do tego trzeba wydłużenie czasu wczytywania strony, które może zniweczyć efekty nawet najlepszego projektu. Czasem wina leży po naszej stronie, czasem – zewnętrznych partnerów, w tym wczytujący się zbyt długo zewnętrzny system reklamowy.

Co istotne, poziomy konwersji i innych parametrów nie są z zasady stałe. Weźmy za przykład sklep internetowy mający współczynnik konwersji w miesiącu średnio na poziomie 2%. Dziennie lub tygodniowo może odnotować duże wahania, ale wzrost lub spadek skuteczności wcale nie musi wynikać z tych zmian. Dopiero porównanie obu wersji: A i B w jednym czasie, gdy poddane są tym samym czynnikom zewnętrznym przyniesie wiarygodne informacje.

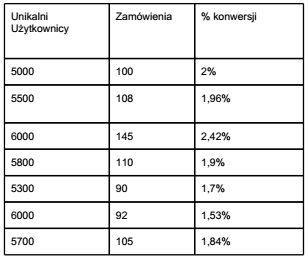

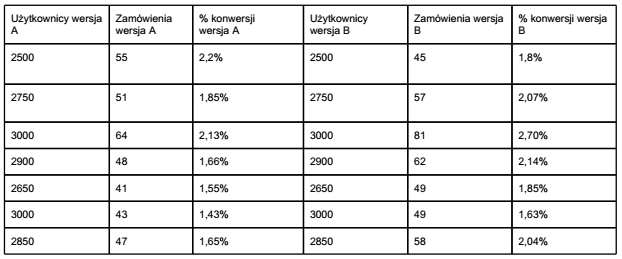

Zobaczmy, jak przedstawia się tabela z danymi tygodniowymi o konwersji dla danego sklepu internetowego. Choć dane są hipotetyczne, odzwierciedlają możliwą sytuację.

To zestawienie na pierwszy rzut oka wskazuje spadek konwersji, który można byłoby usprawiedliwiać właśnie wprowadzonymi zmianami. Jednak, gdy przyjrzymy się danym z podziałem na wersje A i B dla testu przeprowadzonego w tym samym czasie, możemy wyciągnąć kilka ciekawych wniosków.

Średnia konwersja tygodniowa dla wersji A: 1,78%

Średnia konwersja tygodniowa dla wersji B: 2,03%

Różnica B do A w punktach procentowych: 0,25 pkt. proc.

Różnica B do A w procentach: 14,07%

Dane wskazują, że:

- różnica konwersji przedstawiona w punktach procentowych może być niewielka, natomiast wersja B zwiększyła skuteczność strony aż o 14%! To istotna zmiana, zwłaszcza gdy uświadomimy sobie, że znaczy to o 14% więcej zamówień.

- dzienne wahanie konwersji w sklepie wynosi od 1,53% do 2,42%, choć nie jest to wcale najwyższe z możliwych. Przy takich wahaniach próba oceny skuteczności zmian bez testu a/b mogłaby być wątpliwa. Ponadto takie dane trzeba analizować z dłuższej perspektywy czasu.

- spadek skuteczność serwisu ujawnił się w ostatnich dniach. Choć widzimy to w jednej i drugiej wersji, widoczna jest przewaga wersji B. Stąd można byłoby wyciągnąć błędny wniosek, że to właśnie ona działa na niekorzyść serwisu.

Segmentacja statystyk to kolejny krok, po którym należało by sprawdzić zależność konwersji np. od źródeł ruchu, stron docelowych, konkretnych kampanii albo kategorii produktowych. Te działania dadzą podstawę do analizy i następnych testów.

Jak sprawdzić wiarygodność wyników? Istotność statystyczna na ratunek

Czy wyniki, które widzimy w teście na pewno są dowodem na to, że dana wersja działa lepiej? Jest to problem, z którym od dawna borykają się np. koncerny farmaceutyczne testujące nowe leki. Z pomocą przychodzi istotność statystyczna. Wyliczona ze wzoru P-wartość mówi nam, czy wyniki, które obserwujemy, miałyby również szansę pojawić się przypadkowo, gdy test nie był aktualnie prowadzony.

Gotowy kalkulator wyliczający istotność statystyczną można znaleźć na stronie http://visualwebsiteoptimizer.com/ab-split-significance-calculator/. Na ogół przyjmuje się, że p-wartości nie powinien być wyższy niż 0,5. W przeciwnym razie wynik uznaje się za przypadkowy.

Przykłady testowanych zmian

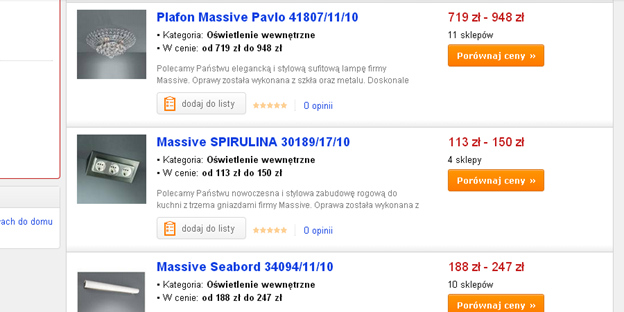

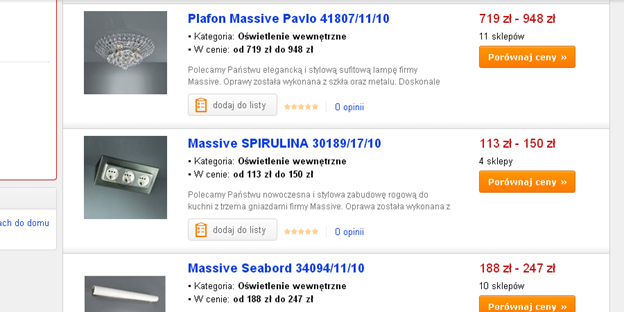

Lista produktów: Zmiana zdjęć 100×100 na 120×120 px

Wybrane kategorie poddaliśmy edycji. Konkretnie dotyczyła ona zdjęć. Mniejsze 100×100 px zastąpiliśmy większymi – 120×120 px. Wyniki były zaskakujące, bo udowodniły, że testom należy poddawać nawet te elementy, które, wydawać by się mogło, nie powinny mieć znaczącego wpływu na konwersję. A jednak…

Wersja A: Zdjęcia 100×100 px:

Wersja B: Zdjęcia 120×120 px:

Wyniki testu wskazują, że użytkownicy, którzy widzieli wersję B, konwertowali aż o 11% lepiej.

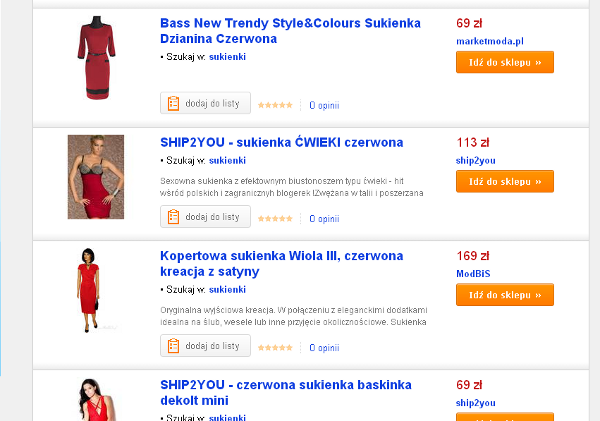

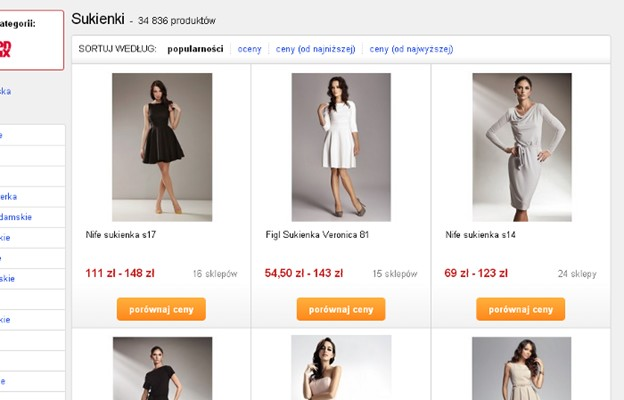

Paski czy kafle?

Po tym doświadczeniu zdecydowaliśmy się na przetestowanie zmian w układzie wyświetlania ofert produktów – dotyczyło to kategorii związanych z modą. Tu wprowadziliśmy układ kaflowy zamiast dotychczasowego paskowego. Zamiast zdjęć 120×120 px wprowadziliśmy zdjęcia 220×220 px, które odgrywają teraz większą rolę niż m.in. nazwa produktu.

Wersja A: dotychczasowy układ paskowy

Wersja B: nowy układ kaflowy

Wynik testu pokazał, że użytkownicy widzący drugą wersję konwertowali o 12% lepiej. Co to oznacza? Bardzo ważne jest, by dostosować treść do potrzeb i profilu użytkownika danej kategorii produktowej. Jak pokazały testy, w kategoriach modowych obraz ważniejszy jest od treści.

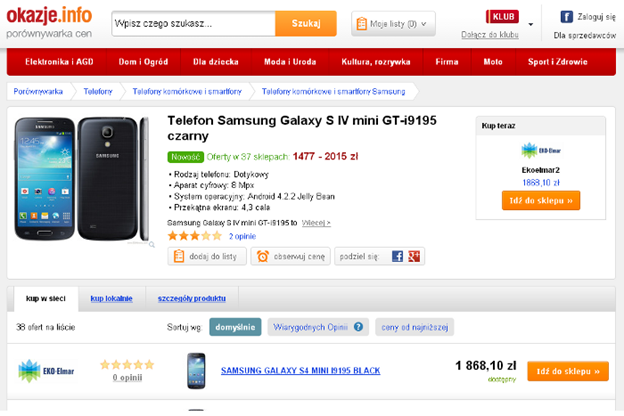

Nowa strona produktu

Praca nad stroną konkretnego produktu trwała dosyć długo. Na przestrzeni dwóch miesięcy stworzyliśmy około 30 makiet z różnymi poziomami dokładności. Ta najlepsza została poddana testom a/b. Oto efekty:

Wersja A: strona dotychczasowa

Wersja B: obszar informacji o produkcie został pomniejszony, a oferty sklepów nie są już sortowane według licytacji. W pierwszej kolejności wyświetlane są trzy najlepsze oferty sklepów, to znaczy z dobrymi opiniami i cenami. To dotychczas największa zmiana, jaką wprowadziliśmy od czasu istnienia serwisu. Niosła za sobą ryzyko niepowodzenia od strony biznesowej, ale przyniosła pożądany efekt – użytkownicy widzący nową wersję strony konwertowali o 6% lepiej.

Wprowadzone zmiany, tzn. umieszczenie elementów konwersyjnych wyżej niż dotychczas i wyświetlanie lepszych ofert przyniósł wzrost konwersji na stronie produktowej. Na tym nie koniec: strona poprawiła wyniki dla innych miar biznesowych, czyli generowany przychód i wartość jednego użytkownika.

Na podsumowanie warto dodać, że dzisiejszy rozwój produktów i usług jest zdecydowanie trudniejszy bez testów a/b. Co prawda, regularne testy są dużym wyzwaniem, jednak warto je wdrażać. Przykład naszej porównywarki pokazuje, że warto poświęcić czas i uwagę właśnie takim testom.

Bartłomiej Dymecki

UX Specialist Okazje.info

Zajmuje się projektowaniem UX, analityką internetową i optymalizacją konwersji. Pracuje w porównywarce cen Okazje.info. W wolnych chwilach prowadzi blog UXFocus.pl. Niektórzy go kojarzyć z publikacji na łamach nieistniejących już Magazynu INTERNET i Internet Makera.