Nowy model dla długiego kontekstu

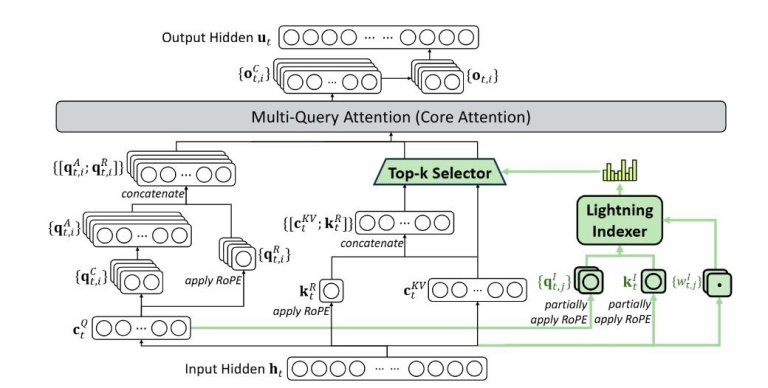

Model V3.2-Exp został oficjalnie ogłoszony w poniedziałek na platformie Hugging Face, a także szczegółowo opisany w artykule naukowym opublikowanym na GitHubie. Jego kluczowym elementem jest DeepSeek Sparse Attention (DSA) – mechanizm, który pozwala modelowi efektywniej radzić sobie z długimi sekwencjami tekstu.

System składa się z dwóch głównych modułów: indeksatora Lightning, który priorytetyzuje istotne fragmenty kontekstu, oraz systemu precyzyjnego wyboru tokenów, który selekcjonuje konkretne jednostki językowe i przekazuje je do ograniczonego okna uwagi modelu.

Dzięki temu, V3.2-Exp może operować na dużych blokach tekstu, zużywając znacznie mniej mocy obliczeniowej.

DeepSeek stawia na tańsze modele AI

Według wstępnych testów przeprowadzonych przez DeepSeek, zastosowanie Sparse Attention pozwala zmniejszyć koszt wywołań API w długim kontekście nawet o 50%. Choć firma zaznacza, że potrzebne są dalsze badania, otwarta dostępność modelu umożliwi szybkie weryfikacje przez niezależne podmioty.

Co ciekawe, DeepSeek już wcześniej próbował obniżać koszty trenowania i utrzymania modeli. Na początku roku firma zwróciła na siebie uwagę branży modelem R1, trenowanym głównie z wykorzystaniem uczenia wzmacniającego i znacznie tańszym od innych rozwiązań dostępnych na rynku amerykańskich. Model ostatecznie nie spełnił pokładanych w nim nadziei, ale potwierdził ambicje DeepSeek w tworzeniu bardziej ekonomicznych alternatyw, czego przykładem jest chociażby nowo zaprezentowany model V3.2-Exp.