Apple tworzy system wykrywania pedofilii

AmerykaŇĄski potentat technologiczny Apple¬†pracuje nad nowym systemem sztucznej inteligencji CSAM, kt√≥ra bńôdzie wykrywańá i zgŇāaszańá uŇľytkownik√≥w, kt√≥rzy przechowujńÖ treŇõci pedofilskie w chmurze iCloud. Algorytm ma oflagowywańá konta uŇľytkownik√≥w, kt√≥re bńôdńÖ posiadańá materiaŇāy zgodne z bazńÖ treŇõci CSAM. Identyfikacja ta ma odbywańá sińô na podstawie haszy. Dzińôki temu firma bńôdzie mieńá moŇľliwoŇõńá zgŇāaszania posiadaczy produkt√≥w Apple do NCMEC (National Center for Missing and Exploited Children).

Apple podkreŇõla jednak, Ňľe przed zgŇāoszeniem materiaŇāy zostanńÖ zweryfikowane. Firma ponadto nie zamierza gromadzińá Ňľadnych informacji na temat treŇõci, kt√≥re mogńÖ mieńá charakter pedofilski, ani nie bńôdzie mieńá dostńôpu do metadanych, czy samych cech wizualnych materiaŇā√≥w, dop√≥ki te nie przekroczńÖ progu alarmujńÖcego zdefiniowanego przez bazńô danych CSAM. Dopiero wtedy Apple bńôdzie zgŇāaszańá moŇľliwoŇõńá popeŇānienia przestńôpstwa do odpowiednich organ√≥w.

AmerykaŇĄski potentat technologiczny twierdzi takŇľe, Ňľe algorytm CSAM jest niezwykle skuteczny i caŇākowicie bezpieczny. Szansa na bŇāńôdne rozpoznanie zdjńôcia jako treŇõci pedofilskiej ma wynosińá jeden na miliard. System jest wspierany technologińÖ kryptograficznńÖ PSI, kt√≥ra pozwala na wykrycie fotografii bez ujawniania jej zawartoŇõci. Z kolei technologia haszujńÖca uŇľywana w systemie to NeuralHash. Jest to algorytm, kt√≥ry analizuje zdjńôcia i konwertuje je w unikalny cińÖg cyfr, kt√≥ry odpowiada poszczeg√≥lnym obrazom w bazie danych CSAM.

Nowy system CSAM Apple ‚Äď zagroŇľenie dla prywatnoŇõci?

Pomimo zapewnieŇĄ firmy, nowy system nie przypadŇā kaŇľdemu do gustu. W internecie podnosi sińô larum, iŇľ moŇľe on byńá powaŇľnym zagroŇľeniem dla naszej prywatnoŇõci. W szczeg√≥lnoŇõci, Ňľe uŇľytkownicy nie bńôdńÖ mieńá dostńôpu do bazy danych CSAM i nie bńôdńÖ wiedzieli, kt√≥re zdjńôcia oflagowane zostaŇāy jako treŇõci pedofilskie. WedŇāug dr. Piotra ŇĀuczuka, miedioznawcy i eksperta ds. cyberbezpieczeŇĄstwa, nikt przy zdrowych zmysŇāach nie bńôdzie negowańá rozwińÖzaŇĄ majńÖcych na celu ograniczenie publikowanych i udostńôpnianych treŇõci o charakterze pedofilskim. JednoczeŇõnie dr ŇĀuczuk widzi tutaj potencjalne zagroŇľenie dla naszego bezpieczeŇĄstwa i wyjaŇõnia, dlaczego uŇľytkownicy Apple mogńÖ czuńá sińô niepewnie.

– Proponowane przez firmńô Apple rozwińÖzanie naleŇľaŇāoby traktowańá pozytywnie, jako formńô zabezpieczenia przed zagroŇľeniami pŇāynńÖcymi z cyberprzestrzeni ‚Äď twierdzi dr Piotr ŇĀuczuk. ‚ÄďOczywiŇõcie pojawiajńÖ sińô uzasadnione obawy o kwestie zwińÖzane z poszanowaniem prywatnoŇõci i wszelkiego rodzaju bŇāńôdy tagujńÖcego zdjńôcia algorytmu. Jednak tw√≥rcy tego rozwińÖzania przekonujńÖ, Ňľe wprowadzane rozwińÖzanie jest w peŇāni bezpieczne ‚Äď m√≥wi dr Piotr ŇĀuczuk.

Dr ŇĀuczuk wspomina teŇľ, Ňľe ograniczenie zaufania po stronie konsument√≥w moŇľe sińô brańá z historii koncernu Cupertino. Ten ma za sobńÖ doŇõńá nieprzyjemne doŇõwiadczenia zwińÖzane z kwestińÖ ochrony prywatnoŇõci. Chodzi tutaj oczywiŇõcie o ujawnionńÖ przez Edwarda Snowdena skalńô inwigilacji uŇľytkownik√≥w w ramach systemu PRISM. W√≥wczas gromadzono dane z serwer√≥w m.in. Google, Facebook, Yahoo, Paltalk, AOL, Skype, YouTube i wŇāaŇõnie Apple.

– StńÖd moim zdaniem wynikajńÖ podstawowe obawy uŇľytkownik√≥w zwińÖzane z wprowadzanym nowym rozwińÖzaniem. W teorii wszystko wyglńÖda obiecujńÖco, jednak naleŇľy mieńá ŇõwiadomoŇõńá, Ňľe algorytm Apple bńôdzie potrzebowaŇā w zasadzie peŇānego dostńôpu do wszystkich zdjńôńá znajdujńÖcych sińô w smartfonie i to jeszcze przed ich archiwizacjńÖ w iCloud. Wymaga to potńôŇľnej mocy obliczeniowej i co uzasadnione stwarza ogromne pole do naduŇľyńá. Miejmy nadziejńô, Ňľe Apple odrobiŇāo lekcjńô w kwestii poszanowania prywatnoŇõci ‚Äď dodaje dr ŇĀuczuk.

Z kolei socjolog i nauczyciel akademicki Uniwersytetu GdaŇĄskiego dr Wojciech Edmund ZieliŇĄski, podkreŇõla, Ňľe jednoznaczna i bezdyskusyjna odpowiedŇļ w tej sprawie jest niemoŇľliwa. WedŇāug niego szeroko pojńôty informatyczny wymiar Ňľycia tj. cyberprzestrzeni nie pozwala w prosty spos√≥b oddzielańá tego, z czego chcemy dla wŇāasnego i wsp√≥lnego dobra korzystańá, od tego, co postrzegamy jako dla nas niepokojńÖce lub wprost niepoŇľńÖdane.

– Ale w pewnym sensie to jest problem ‚Äěodwieczny‚ÄĚ, wszak nie od dzisiaj rozmaite nasze wytwory najzwyczajniej r√≥wnieŇľ utrudniajńÖ nam Ňľycie. BŇāńôdem byŇāoby jednak pozostawianie tego zagadnienia jakiemuŇõ ‚Äěswojemu biegowi‚ÄĚ, z nadziejńÖ, Ňľe sygnalizowane obawy o nieuprawnionńÖ inwigilacjńô i problemy z tych obaw wynikajńÖce rozwińÖŇľńÖ sińô same. Im bardziej otwarta, krytyczna i wnikliwa bńôdzie ekspozycja i dyskusja wszelkich pojawiajńÖcych sińô wńÖtpliwoŇõci, tym wińôksze prawdopodobieŇĄstwo, Ňľe dobre rozwińÖzania informatyczne, organizacyjne itp. bńôdńÖ demaskowaŇāy i ograniczaŇāy pola rozmaitych, moŇľliwych lub faktycznych naduŇľyńá ‚Äď podkreŇõla dr ZieliŇĄski.

Apple chce informowańá rodzic√≥w o tym, Ňľe ich dzieci oglńÖdajńÖ porno

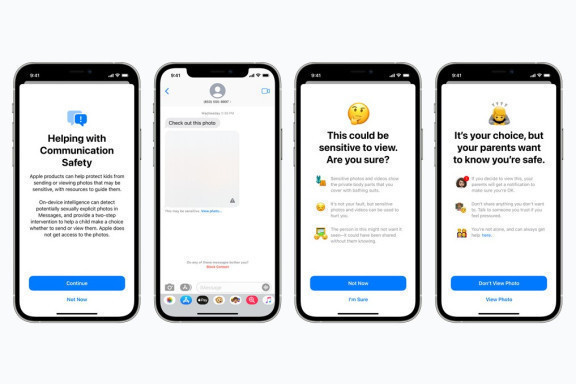

Marka de facto wprowadza szereg aktualizacji do swojego systemu i poza wykrywaniem treŇõci pedofilskich, chce takŇľe rozszerzyńá opcjńô kontroli rodzicielskiej. Firma ma zamiar udostńôpnińá rodzicom moŇľliwoŇõńá zablokowania zdjńôńá erotycznych dla uŇľytkownik√≥w poniŇľej 18 roku Ňľycia i wysyŇāańá powiadomienia, kiedy np. dziecko w wieku poniŇľej 13 lat obejrzy bńÖdŇļ przeŇõle tego typu fotografie.

JeŇõli rodzice wyraŇľńÖ zgodńô na tńô opcjńô, iPhone’y nieletnich uŇľytkownik√≥w bńôdńÖ skanowańá zdjńôcia przychodzńÖce i wychodzńÖce za pomocńÖ klasyfikatora obraz√≥w. Algorytm w tym przypadku ma oflagowywańá treŇõci o ‚Äěcharakterze jednoznacznie seksualnym‚ÄĚ. JeŇõli system wykryje takie zdjńôcie, zasŇāania je i pyta uŇľytkownika, czy naprawdńô chce je wysŇāańá bńÖdŇļ wyŇõwietlińá. JeŇõli jednak uŇľytkownik jest osobńÖ maŇāoletnińÖ, tj. poniŇľej 13 roku Ňľycia, rodzic otrzyma specjalne powiadomienie, iŇľ dany materiaŇā erotyczny zostaŇā przez nie wyŇõwietlony. Firma zapewnia, Ňľe w tym przypadku system nie zgŇāasza niczego ani do moderator√≥w Apple, ani do zewnńôtrznych podmiot√≥w.

Nowa aktualizacja iOS bardzo mocno podzieliŇāa konsument√≥w, ale r√≥wnieŇľ ekspert√≥w od cyberbezpieczeŇĄstwa czy kryptografii. CzńôŇõńá z nich, jak Mihira Bellare, David Forsyth czy Dan Boneh uwaŇľajńÖ, iŇľ Apple wykonaŇā krok w dobrym kierunku. Wielu specjalist√≥w czy organizacji wyraŇľa jednak sprzeciw czy swoje obawy w zwińÖzku z nowymi algorytmami firmy. Tymi postanowiŇāo sińô podzielińá aŇľ 36 organizacji i 7427 developer√≥w i ekspert√≥w ds. cyberbezpieczeŇĄstwa, kt√≥rzy podpisali list otwarty do amerykaŇĄskiej firmy.

W liŇõcie czytamy: ‚ÄěPodczas gdy wykorzystywanie dzieci jest powaŇľnym problemem, a wysiŇāki zmierzajńÖce do jego zwalczania sńÖ niemal bezsprzecznie podejmowane w dobrych intencjach, propozycja Apple wprowadza backdoora, kt√≥ry grozi podwaŇľeniem fundamentalnej ochrony prywatnoŇõci wszystkich uŇľytkownik√≥w produkt√≥w Apple. Proponowana technologia dziaŇāa poprzez cińÖgŇāe monitorowanie zdjńôńá zapisanych lub udostńôpnionych na iPhonie, iPadzie lub Macu uŇľytkownika. Jeden system sprawdza, czy w pamińôci iCloud zostanie wykryta pewna liczba budzńÖcych zastrzeŇľenia zdjńôńá, i ostrzega o tym podmioty publiczne. Inny powiadamia rodzic√≥w dziecka, jeŇõli iMessage jest uŇľywany do wysyŇāania lub odbierania zdjńôńá, kt√≥re algorytm uwaŇľa za zawierajńÖce nagoŇõńá. Jako Ňľe obie kontrole sńÖ przeprowadzane na urzńÖdzeniu uŇľytkownika, mogńÖ one potencjalnie ominńÖńá wszelkie szyfrowanie typu end-to-end, kt√≥re w przeciwnym razie chroniŇāoby prywatnoŇõńá uŇľytkownika.”

Apple jednak zdementowaŇāo obawy tw√≥rc√≥w listu i prosi swoich uŇľytkownik√≥w o zaufanie w tej kwestii. Czas pokaŇľe, jak bardzo skutecznym jest nowy algorytm firmy.