Modele korzystają z architektury MoE, a według Mety w niektórych obszarach przewyższają konkurencję. Nowościom towarzyszą jednak licencyjne ograniczenia, które mogą zablokować dostęp użytkownikom z UE.

Kolekcja Llama 4 powiększa się

Nowe modele zostały przeszkolone na dużych zbiorach nieoznakowanych danych tekstowych, graficznych i wideo, co ma zapewnić im zaawansowane możliwości multimodalne i szerokie zrozumienie treści wizualnych.

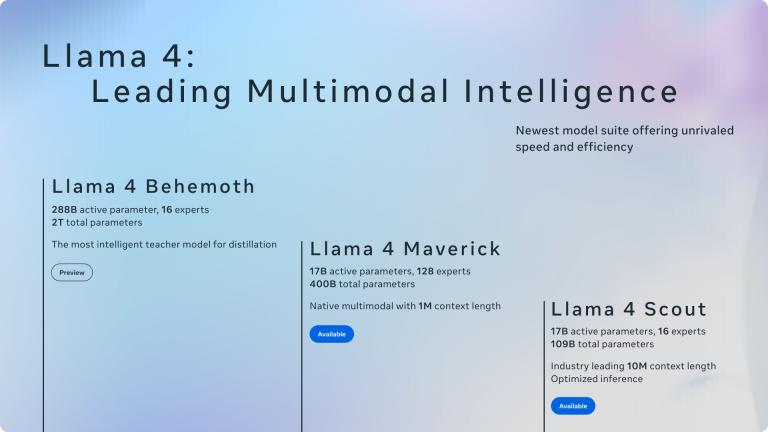

Modele Scout i Maverick są już dostępne publicznie poprzez Llama.com i platformę Hugging Face. Behemoth pozostaje niedostępny – nadal trwa jego trening. Jednocześnie Meta zaktualizowała swojego AI-asystenta, dostępnego m.in. w WhatsApp, Messengerze i Instagramie – od teraz działa on w oparciu o Llama 4 w 40 krajach. Multimodalne funkcje są jednak na razie ograniczone do użytkowników w USA i tylko w języku angielskim.

Nowa architektura MoE

Llama 4 to pierwsza kolekcja modeli Meta wykorzystujących architekturę mixture of experts (MoE). Tego typu rozwiązanie umożliwia efektywniejsze zarządzanie obliczeniami – dane są dzielone na mniejsze zadania i kierowane do wyspecjalizowanych „ekspertów”. Maverick ma 400 miliardów parametrów, ale w czasie działania aktywnych jest tylko 17 miliardów z 128 dostępnych ekspertów. Scout, z kolei, ma 109 miliardów parametrów całkowitych, 17 miliardów aktywnych i 16 ekspertów.

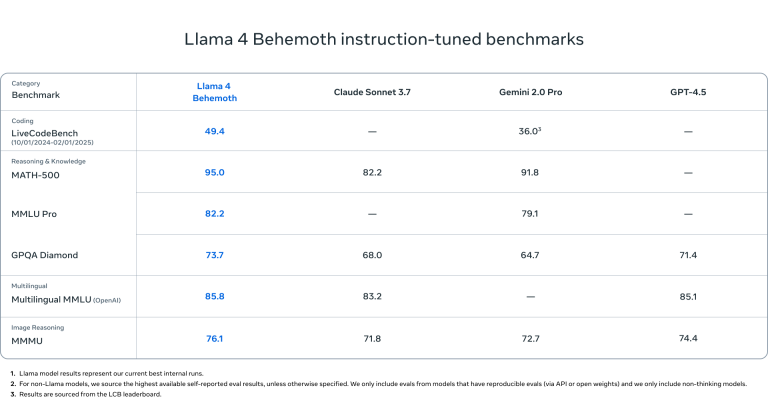

Według Meta, Maverick – dedykowany do zadań ogólnych, jak kreatywne pisanie czy czat – w wybranych benchmarkach przewyższa GPT-4o (OpenAI) i Gemini 2.0 (Google). Nie dorównuje jednak najnowszym modelom takim jak Gemini 2.5 Pro, Claude 3.7 Sonnet czy GPT-4.5.

Scout sprawdza się szczególnie w streszczaniu dokumentów i analizie dużych baz kodu. Ma imponujące okno kontekstowe – aż 10 milionów tokenów, co pozwala mu pracować na bardzo długich dokumentach. Scout może działać na jednym procesorze graficznym Nvidia H100, podczas gdy Maverick wymaga już systemu Nvidia H100 DGX.

Największy model – Behemoth – będzie potrzebował jeszcze mocniejszych zasobów. Ma 288 miliardów aktywnych parametrów, 16 ekspertów i blisko 2 biliony parametrów ogółem. W testach wewnętrznych przewyższa GPT-4.5, Claude 3.7 Sonnet oraz Gemini 2.0 Pro w zadaniach STEM, choć nadal ustępuje Gemini 2.5 Pro.

Kontrowersje licencyjne i zmiany w odpowiedziach modeli

Pomimo otwartego dostępu, Meta zastrzega możliwość korzystania z Llama 4 dla użytkowników i firm z UE – blokując ich dostęp z uwagi na europejskie regulacje dotyczące AI i prywatności danych. Ponadto, podobnie jak w przypadku poprzednich wersji Llama, firmy posiadające ponad 700 milionów aktywnych użytkowników miesięcznie muszą uzyskać od Meta specjalną zgodę licencyjną.

Maverick na pokaz? Społeczność AI reaguje

Maverick zajął drugie miejsce w rankingu LM Arena – teście, w którym ludzie porównują odpowiedzi generowane przez różne modele i wybierają te, które uznają za lepsze. Jednak według badaczy AI, którzy analizowali komunikaty Mety i zachowanie modelu w praktyce, wersja Mavericka użyta w teście nie jest identyczna z tą, którą Meta udostępnia publicznie.

W oficjalnym ogłoszeniu firma zaznaczyła, że wersja Mavericka na LM Arena to „eksperymentalna wersja czatowa”. Równocześnie na stronie internetowej Llama pojawiła się informacja, że testy LM Arena przeprowadzono z użyciem „Llama 4 Maverick zoptymalizowanego pod kątem konwersacyjności”.

Znaczące różnice

Społeczność badaczy zauważa, że taka praktyka może wprowadzać w błąd. Choć LM Arena od dawna nie cieszy się reputacją w pełni wiarygodnego miernika wydajności modeli AI, firmy zazwyczaj nie dostosowywały swoich modeli specjalnie pod ten test — lub przynajmniej nie przyznawały się do takich działań. W przypadku Mety mamy do czynienia z sytuacją, w której wersja zoptymalizowana pod konkretny benchmark nie została udostępniona publicznie, a deweloperzy otrzymali inną, tzw. „waniliową” wersję modelu.

Problemem, jak wskazują eksperci, jest utrudnienie przewidywania, jak model będzie zachowywać się w praktycznych zastosowaniach. Dodatkowo, benchmarki – mimo ograniczeń – powinny oferować spójne i przejrzyste porównanie modeli.

Badacze AI zauważyli także istotne różnice w zachowaniu modeli. Publicznie dostępna wersja Mavericka znacząco różni się od tej z LM Arena – wersja testowa częściej używa emotikonów i generuje bardzo rozbudowane odpowiedzi. Te rozbieżności tylko pogłębiają wątpliwości dotyczące transparentności praktyk Mety w zakresie prezentowania wydajności swoich modeli AI.