Sztuczna inteligencja w polskim biznesie

Rozwój sztucznej inteligencji zmienia oblicze globalnej gospodarki, a Polska nie jest tu wyjątkiem. Firmy coraz częściej sięgają po rozwiązania AI w celu m.in. poprawienia efektywności operacyjnej i zdobycia przewagi konkurencyjnej. O tym, i nie tylko, czytamy w najnowszym raporcie PwC Polska „Gotowi na sztuczną inteligencję. Oczekiwania polskich konsumentów i firm”, który dostarcza wielu informacji m.in. na temat czynników decydujących o powodzeniu lub niepowodzeniu wdrożeń AI. Wśród respondentów znalazło się 115 firm w Polsce o szerokim przekroju (duże przedsiębiorstwa osiągające przychód do 2 miliardów złotych rocznie oraz mniejsze przedsiębiorstwa z rocznym przychodem nie przekraczającym 200 mln).

AI: work in progress

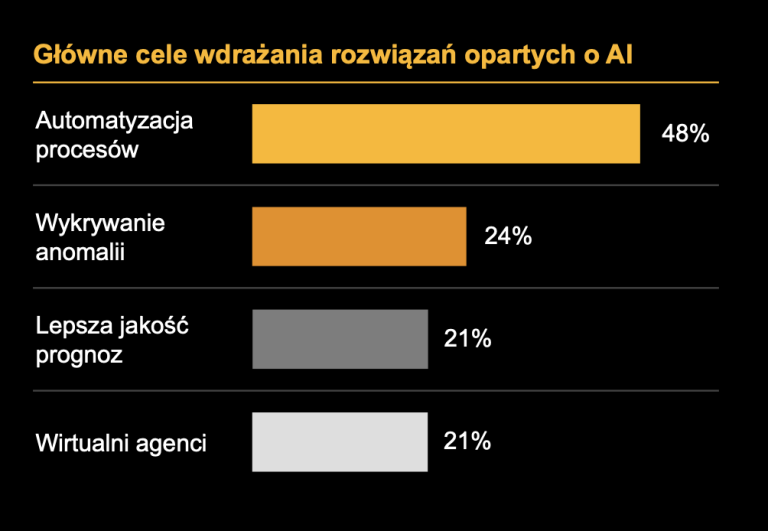

Według przeprowadzonych analiz, 75% firm rozpoczęło inwestycję w AI, ale nikt nie ma jeszcze wielu produkcyjnych zastosowań, większość jest na etapie wstępnym. AI wdrażana jest głównie w celu automatyzacji procesów i poprawy jakości prognoz biznesowych. Warto wspomnieć, że aż 80% pracowników korzysta przy swoich obowiązkach ze sztucznej inteligencji, chociaż ich pracodawcy na to nie zezwalają.

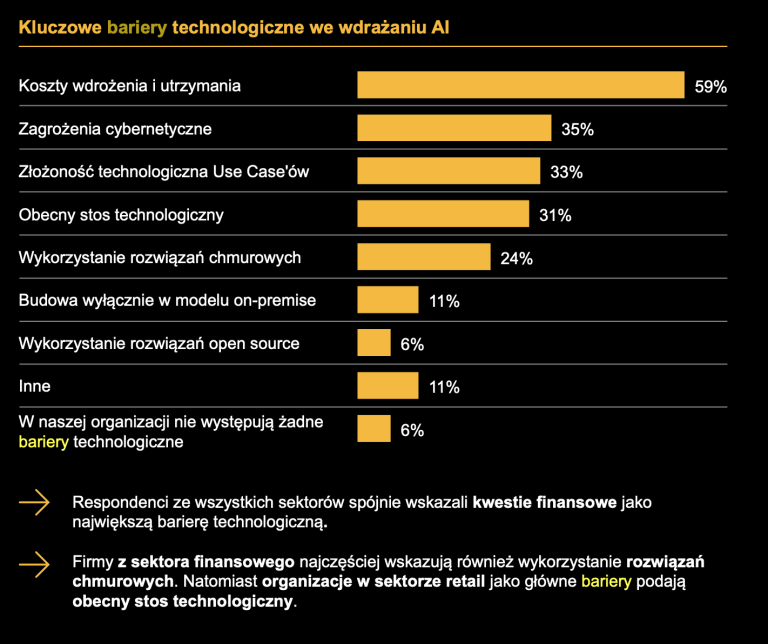

Mimo entuzjazmu wobec tej technologii, wiele organizacji nadal boryka się z brakiem strategii wdrożeniowej oraz trudnościami w rekrutacji specjalistów, co dodatkowo hamuje pełne wykorzystanie potencjału AI w firmach. Respondenci ze wszystkich sektorów spójnie wskazali kwestie finansowe jako największą barierę technologiczną.

Pomijając jednak te wyzwania, polski biznes upatruje w sztucznej inteligencji klucza do rozwoju. Przedsiębiorstwa wymieniają automatyzację, wykrywanie anomalii, lepszą jakość prognoz oraz wirtualnych agentów jako czynniki decydujące o wdrożeniu AI do przedsiębiorstwa.

Co składa się na sukces AI w biznesie?

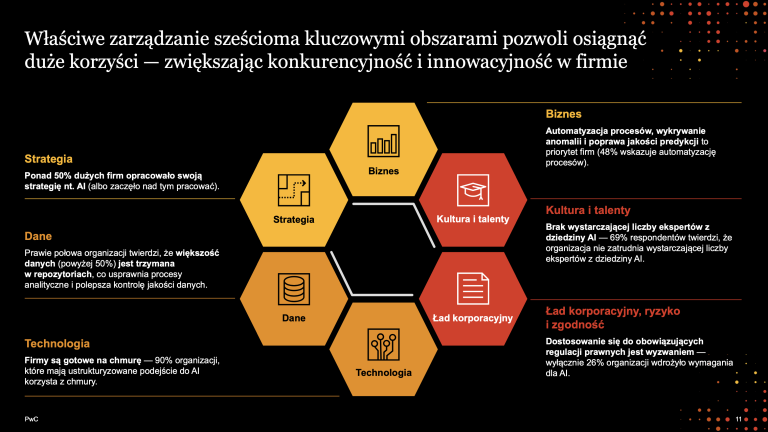

Z raportu wynika, że firmy, które osiągają najlepsze wyniki, integrują AI w sześciu kluczowych obszarach. Wśród nich wymienia się: strategię, biznes, kulturę i talenty, ład korporacyjny, technologię i dane.

Firmy implementujące AI jako narzędzie do poprawy efektywności, a nie traktujące ją jedynie jako technologiczną nowinkę, mają większe szanse na sukces. Prawie połowa organizacji twierdzi, że większość danych (powyżej 50%) jest trzymana w dedykowanych repozytoriach, co usprawnia procesy analityczne i polepsza kontrolę jakości danych.

Dlaczego AI nie zawsze oznacza sukces?

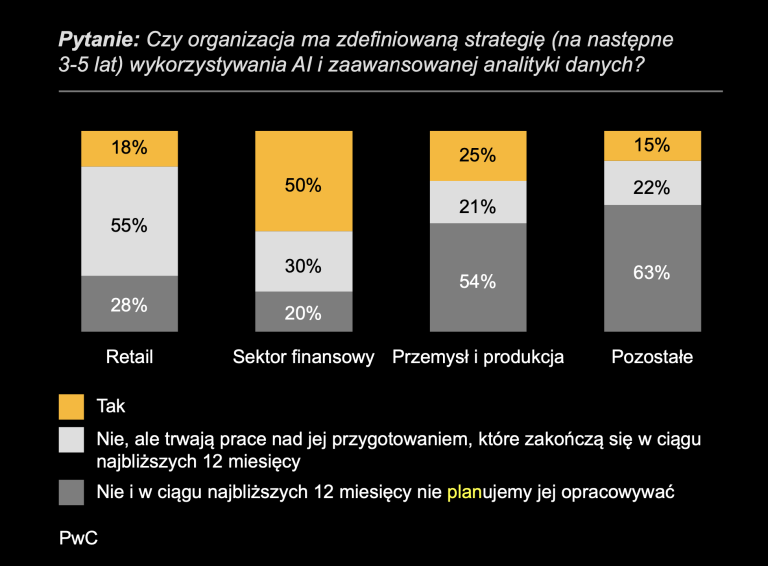

Pomimo rosnącego zainteresowania, wiele firm nie opracowało jasnej strategii tego, w jaki sposób wykorzystać tę technologię. Według raportu nie wszystkie firmy zdefiniowały jeszcze plan działania, projekty zaś są realizowane bez spójnego planu, co często kończy się niepowodzeniem. Wielu przedsiębiorstwom brakuje wystarczającej wiedzy technicznej, brakuje też specjalistów ds. wdrożeń – 69% respondentów twierdzi, że firmy nie zatrudniają ekspertów z zakresu AI.

Regulacje prawne związane z AI

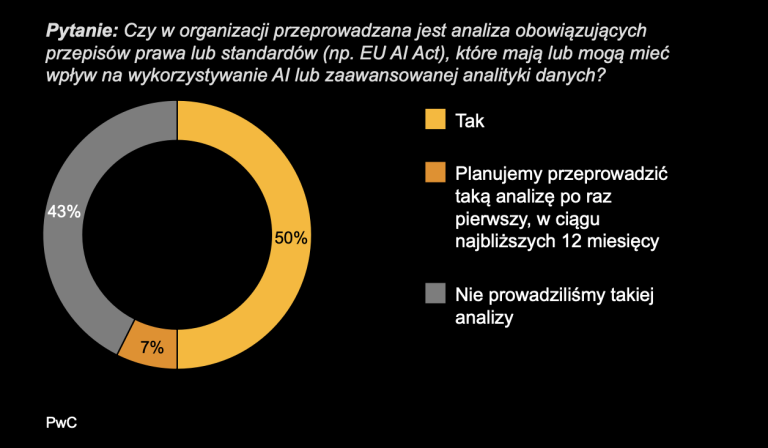

O potrzebie regulacji prawnych w przypadku korzystania z AI mówiono wiele, stąd mamy np. europejski AI Act, który wymaga od firm odpowiedzialnego zarządzania ryzkiem związanym ze sztuczną inteligencją. Z tego powodu większość firm przeprowadza analizy przepisów, jednak niewielka część wdrożyła odpowiednie procesy do zarządzania ryzykiem.

– Profilaktyka przyszłości z pewnością należy do AI w postaci osobistego, dyskretnego asystenta, trenowanego na indywidualnym profilu medyczno-behawioralnym użytkownika. Należy jednak pamiętać, że chociaż “ultymatywna meta-technologia” AI, mimo że ulepsza praktycznie każdą dziedzinę naszego życia, to medycyna i preventive healthcare stanowią szczególne wyzwania, nie tylko technologiczne, ale również regulacyjne. Czy modele trenowano na legalnie pozyskanych danych? Na jakiej populacji zbudowano bank i czy wnioski można aplikować w innych populacjach? Jak gwarantowana jest poufność, by ewentualny incydent, którego ryzyko rośnie z wielkością i wartością bazy, nie pozwalał na identyfikację konkretnych osób? Te i inne pytania, dotyczące prawnej odpowiedzialności za “diagnozę” stawianą przez AI oraz walidacji poprawności medycznej produktu, to bardzo istotne kwestie do rozważenia. Oczywistym wyzwaniem jest też kosztowność projektów, wymagających angażowania wysokiej klasy inżynierów, lekarzy i prawników – podsumowuje Lesław Sierocki, Chief Product Officer z Wellysa | Preventive Health Services.

– Budowa zaufania do AI wymaga zaangażowania w ład korporacyjny, ocenę ryzyka i zapewnianie zgodności. Analiza i ocena przepisów prawa lub standardów jest pierwszym krokiem. Kolejnym jest wdrożenie zasad i praktyk odpowiedzialnej sztucznej inteligencji m.in. poprzez spójny governance framework i system zarządzania ryzykiem. Pozytywnym sygnałem — pomimo że tylko 40% organizacji przeprowadziło szkolenia z zakresu bezpiecznego Korzystania z AI — jest fakt, że firmy dostrzegają ryzyka specyficzne dla tej technologii, tj. naruszenie zasad etycznych i praw własności intelektualnej (sektor finansowy), brak jasnej odpowiedzialności za wyniki i podjęte decyzje (sektor retail) – mówi Mateusz Szajdak, menadżer, PwC Polska.